Cum de a închide site-ul din motoarele de căutare toate metodele cunoscute - promovarea webline

Pentru orice site a apărut în rezultatele de căutare, acesta ar trebui să fie pre-indexate, care este indexat de motorul de căutare păianjeni. Următoarea etapă - clasament - definirea spațiului de resurse în problema. Acesta este influențată de o serie de criterii, printre care cele mai relevante - măsura în care rezultatele emiterii cererii de utilizator. Site-ul pentru a fi mai relevante, este necesar să se reglementeze circulația și comportamentul robotului de căutare pe ea. Ca o regulă, de la motoarele de căutare și a ascunde paginația, filtre, serviciul și paginile care conțin datele personale ale utilizatorilor. În acest articol, vom lua în considerare toate căile cunoscute de a închide un document din motoarele de căutare, și explică ce pot fi utile pentru fiecare dintre ele.

robots.txt

Cel mai comun mod de a specifica o căutare roboți de pagini prezentate sau, dimpotrivă, închis pentru a vizita un robots.txt. Acesta este un fișier text simplu localizat în directorul rădăcină al resursei de Internet care descrie instrucțiunile pentru roboții de căutare.

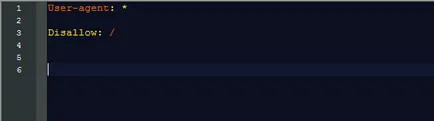

Pentru a închide imediat întregul site-ul de a fi indexate, va trebui să se înregistreze în fișierul robots.txt doar două linii:

În acest manual, raportați că se aplică tuturor motoarelor de căutare (User-agent: *); al doilea rând (Disallow: /) înseamnă că interdicția se aplică tuturor paginilor site-ului.

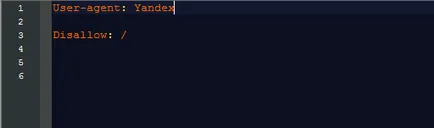

Dacă este necesar, închideți resursa numai pe un motor de căutare în linia User-agent: specificați pentru ce a fost. Mai des decât motoarele de căutare prescrise Yandex și Google:

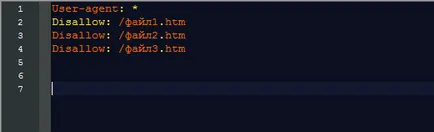

Disallow linie poate conține, de asemenea, instrucțiuni cu privire la părți, capitole sau dosare site-ul individual, care nu sunt de dorit pentru accesarea cu crawlere roboți.

Pentru a dezactiva indexarea:

- folder specific - a pus această echipă Disallow: / director /;

- File List - specificați întreaga listă în următorul format:

Trebuie avut în vedere faptul că robots.txt este percepută de către motoarele de căutare în diferite moduri, și roboți Google nu urmați întotdeauna instrucțiunile sale, percepe conținutul fișierului ca recomandare.

Roboți registre meta tag din etichetă

html-documente, are următoarele valori:Principiul de funcționare a acestor meta tag-uri este aceeași ca și în cazul de robots.txt. Singura excepție - acestea sunt utilizate în mod direct pe paginile de care trebuie să fie închise. Dacă vorbim despre toate etichetele de date a resurselor prescrise direct în șablonul de site-ul web. Exemplu de meta roboți:

Aceasta spune că robotul este interzis să indexa paginile și a obține link-uri.

Iată câteva tag-uri utile:

- meta name = »roboți» content = »noimageindex» - interzice imaginile index de pe pagina pe care este utilizat;

- meta name = »roboți» content = »none» - folosit pentru a însemna «NOINDEX, nofollow».

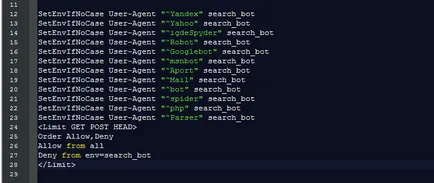

fișier .htaccess

- Blocați roboții de căutare utilizând următoarele comenzi:

Pentru fiecare motor de căutare - o linie separată.

- Interzice accesul la toate fișierele și directoarele:

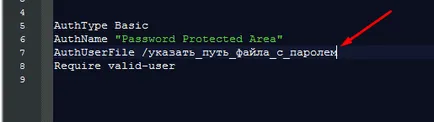

- Limita cu o parolă pentru a accesa site-ul sau pagina. Pentru a face acest lucru, a pus acest .htaccess următorul cod:

Preparate pentru proprietarii de site-uri WordPress la

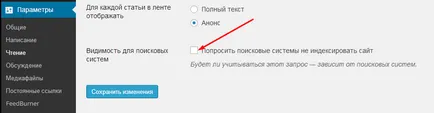

Dacă se întâmplă să fie proprietar al resursei pe WordPress, puteți închide site-ul dvs. de a fi indexate folosind admin în sine, care a făcut doar câteva clicuri de mouse:

- În meniul admin, mergeți la fila Setări;

- Selectați Reading;

- bifați caseta pe punctul de a „solicita motoarelor de căutare să nu indexeze site-ul“;

- salvați modificările.

Există, de asemenea, un număr de SEO-in-uri, de exemplu, «All in One SEO Pack», cu care puteți controla indexarea anumitor documente ale site-ului.

Alte CMS, de asemenea, pot include caracteristici similare și plug-in-uri.

Orice ai ales calea de închidere a indexării, amintiți-vă că mijloacele cele mai fiabile de a ajunge la index - pentru a menține site-ul de pe serverul este deconectat de la World Wide Web.

- Pentru orice site a apărut în rezultatele de căutare, acesta ar trebui să fie pre-indexate, care este indexat de motorul de căutare păianjeni. Următoarea etapă - clasament - definirea spațiului de resurse în problema. Acesta este influențată de o serie de criterii, printre care cele mai relevante - măsura în care rezultatele emiterii cererii de utilizator. Site-ul pentru a fi mai relevante, este necesar să se reglementeze circulația și ...