Cum de a identifica o pagină dublă, blog Nikolai Ivanov

Omulețul se poate face mult.

[Adsense]

Stimați colegi!

Mă bucur să întâlnesc pe blog-ul meu.

Astăzi vreau să vă spun despre paginile duplicat.

Și cel mai important, cum să dezvăluie o pagină dublă. care creează WordPress.

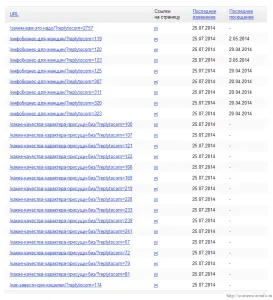

Mulți oameni știu și nu știu. De asemenea, am intrat în rândurile lor. O dată, când am început să verifice rezultatele site-ului de indexare pe Yandex. și am văzut adresa URL a paginii cu un post scriptum de neînțeles: replytocom.

Iată cum arăta:

maxilarului meu a scăzut doar când am văzut numerele lor. La urma urmei, de fapt, aceste pagini duplicat pagina principală, selectând suc de link-ul lor.

Adevărul este că, după un atac hacker site-ul meu a căzut în vizitele și nu a vrut să câștige vizitatori. Am început să caute cauzele. Și când m-am dus la Yandex.webmaster. pentru a verifica indexare, am găsit 297 de pagini duplicat.

(Click pe pagina pentru a mări)

Replytocom - ce este?

Am început să studieze problema de pe Internet. Mulți susțin că de la adoptarea traficului măsuri site-ul va crește de 10 ori. Deci, pentru mine că ar trebui să fie. Dar Dumnezeul meu, ce este? Mi se pare că-ia paginile cu alte postscripturile:

Cum de a identifica o pagină dublă?

Acesta poate fi vizualizat pe Google.

Introduceti site-ul dvs. interogare de căutare: mysite.ru/tag și motorul de căutare vă va oferi toate duplicate ale paginii cu o etichetă notă. În schimb mysite intră în domeniul site-ului.

Acum, sarcina principală este de a scăpa de aceste pagini. Pentru a face acest lucru, deschideți pagina în yandex.webmaster Ștergere URL și o șterge un fișier cu un post-scriptum.

Ei, desigur, nu este șters imediat, dar va dispărea pe măsură ce trece prin robot de pe site-ul dumneavoastră. Cu toate acestea, puteți șterge numai acele pagini care sunt deja indexate de motoarele de căutare. În caz contrar, doriți pentru a preveni pagini de index păianjeni motor de căutare ia imediat.

Cum pot preveni indexarea duble pagini?

După cum știți (sau nu) are un fișier robots.txt. lectură robotul care efectuează operațiunea, ceea ce ia permis.

Prin urmare, aveți nevoie pentru a face acest fișier interdicția de apel la motoarele de căutare ia pagini diferite postscripts. A se vedea imaginea de mai jos cum se face:

Nu uitați să faceți o copie a fișierului robots.txt. Numai atunci se poate face modificări. Modificarea fișierului, salvați și încărcați fișierul în găzduire.

Cât timp să aștepte înainte de un trafic site-ul creștere de zece ori nu știu. De exemplu, prezența mea într-o lună nu este crescut cu o iotă.

Nu vreau să spun că locul de muncă de a scoate pagini duplicat pentru a le face. Este necesar și obligatoriu. Dar, în detrimentul creșterii participării încă am îndoieli. Dar noi așteptăm și să vedem.

Acum știi cum să identifice o pagină dublă pe site-ul și cum să le împiedică să indexeze.

În prezent, am totul.

Cu stimă, Nikolay Ivanov.