Cum de a crea roboți txt fișier pentru WordPress, webmaster note

Acest articol va vorbi despre optimizarea blog-ul dvs. utilizând un fișier robots.txt, ascutit-l pentru motoarele de căutare și de ce este necesar să se facă acest lucru.

Cum de a crea roboți txt pentru WordPress?

Nu este nici un secret faptul că mai mult de 70-80% din traficul pe site-ul nostru vine de la motoarele de căutare sau de căutare (PS).

Mulți dintre voi care au propriile lor bloguri personale sau site-uri pentru a le scrie articole interesante. astfel, încercând să ajute oamenii să rezolve problemele lor imediate într-o anumită zonă.

Unii bloggeri spun că nu au nevoie pentru a optimiza site-ul (“... de ce acest Roboți txt? ...») și faptul că se va ajunge la un număr mare de persoane, deoarece acestea au un articol unic ...

Cum de a crea roboți txt

Roboți va instala fișierul pe blog-ul dvs. WordPress, și de a crește astfel fluxul de vizitatori la SS pe resursele lor!

Faptul că sistemul de director Wordpres s este o mulțime de script-uri de sprijin, pagini, fișiere, care pur și simplu trebuie să fie închise de către roboți de indexare.

Cele mai importante Robots txt pentru WordPress este că acesta se află la rădăcina blogului și a explicat clar toate opțiunile pentru motoarele de căutare, care indică faptul că doriți să indice un blog și ceea ce nu este.

Acum, creați fișierul, înregistrați-l și setați opțiunile dorite pe blog-ul nostru. Creați un robots.txt pentru WordPress în două moduri:

Plugin-ul este numit «KB Robots.txt». Este foarte simplu, iar pe setările de pagină are doar o singură fereastră de forma în care și necesitatea de a face toți parametrii necesari (vezi mai jos), apoi apăsați butonul «Submit» pentru a salva.

Aici este versiunea mea a fișierului robots.txt pe blog-ul meu:

Probleme cu indexarea blog-ul dvs.

În acest caz, dacă site-ul nu este plugin necesar pentru a afișa link-uri CNC. poate exista o problemă atunci când indexarea paginilor.

Linie în fișierul robots.txt:

doar să interzică indexarea paginilor de acest tip. Prin urmare, pentru a evita problemele, vă sugerez să mergeți la link-ul de mai sus și să personalizați linkurile CNC pentru blogul său.

După cum puteți vedea eu nu folosesc Disallow interzicerea robotului Google :? / * * În robots.txt, și tu nu sfătui. Numai Yandex!

Astfel, aceste pagini duplicat, veți avea o mulțime de în SERPs, cum ar fi Google. Aceasta ar implica autorizarea motorului de căutare.

Atunci va fi prea târziu să se plâng de faptul că blogul dvs. nu poate urca la pozițiile de vârf, și că traficul a scăzut de mai multe ori.

Pentru a face acest lucru, du-te prin directorul rădăcină FTP, și apoi blog-ul dvs. pentru a edita fișierul .htaccess deschide. Apoi, montați-l în aceste cuvinte acolo:

Asta e tot. Acum, în cazul în care robotul va trece la o pagină duplicat, redirecționează imediat la pagina principală.

roboți corecte txt

Apropo, această versiune a fișierului robots.txt nu este adevărul suprem. Dar acest lucru este robots.txt corect .I cred.

Acest lucru se datorează faptului că există mai multe opinii cu privire la corectitudinea și oportunitatea de a scrie sau nu, a anumitor directive din dosar.

Un răspuns clar la această întrebare poate fi doar programatori PS.

Aici sunt cel mai important rezultat, iar rezultatul în acest moment este după cum urmează:

- Panoul de Google și Yandex webmasterul nu există erori și comentarii despre fișier robots.txt

Observ că fișierul corect munca mea. Am verificat acest lucru de multe ori, efectuarea de audituri de blog cu diverse servicii.

Și acum mai mult de un truc de la mine. Dacă aveți încă un blog tânăr, dar acest lucru nu este necesar, dar cu siguranță utile în viitor.

A scăpa de sarcina pe server

Vorbesc despre sarcina crescută pe server atunci când scanează robotul blog-ul de căutare. Pentru a scapa de ea, trebuie să vă înregistrați în robots.txt întârziere dvs. crawl directivă fișier.

Asigurați-l destul de ușor. Prescrierea valoare de crawl-întârziere: 10 după valorile Disallow, se lasă.

roboți actualizate txt pentru WordPress.

Prieteni, și informații acum foarte importante! Dacă te uiți la roboții mei txt fișier, veți vedea că nu este similar cu cel pe care am sugerăm să instalați pe blog-ul dvs. mai devreme în acest articol. Și toate acestea pentru că, din păcate, nu funcționează.

Da, da, ai auzit bine. Ea nu funcționează! Faptul că el nu interzice de fapt indexarea de subiecte, cum ar fi tag-ul, pagina, hrana pentru animale, atașament, comment-pagină, trackback și categoria. Acest lucru duce la apariția de pagini duplicat, care este, duplicat de conținut. Și dublează paginile, la rândul său, poate duce la filtrele motoarelor de căutare.

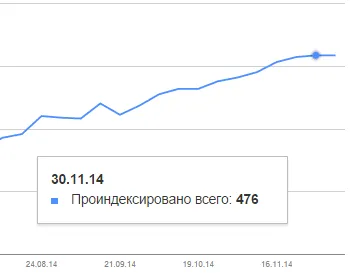

Acest „turmă“, a remarcat blogger respectat Alexander Borisov și a spus despre el într-un articol pe blogul isif-life.ru său. A fost un șoc pentru mulți bloggeri. În rezultatele unor zeci de mii de pagini cu camere duble. Blog-ul meu, de asemenea, a scăzut sub distribuție. Uită-te la cât de mult am pagini în indexul Google:

Și în ciuda faptului că am scris 98 articole! 476-98 = 378 pagini durează. Pfiu ... Am avut noroc ...

Dar situația de pe blog-ul meu se schimbă, programul este deja stabilizat și în curând aceste pagini duplicat vor fi mai puțin și mai puțin! Datorită Alexander pentru ajutor!

Prin urmare, trebuie să citiți articolul despre Aleksandra Borisova isif-life.ru blog despre cum să eliminați duplicate ale acestor pagini. Dar eu îndrăznesc să spun că nu toate informațiile furnizate în articol.

Apropo, vă recomand să citiți articolul despre mikrorazmetke. Acesta este un subiect foarte important și de mare ajutor în promovarea blog-ul dvs.!

Mult noroc pentru tine și noroc Cu respect,

Alte articole de interes:

Cartea este despre câștigurile în Internet:

Serghei, am câteva întrebări, dar nu sunt sigur ce articol este mai bine să ceară, prin urmare, cred că vor fi mai relevante.

A se vedea, pentru o astfel de pagina de index apar Google (mai jos). Aveți întrebări:

1 Nu avem nevoie de acele pagini din index?

2 Dacă „nu“, ambele din otindeksatsii apropiate în robots.tht sau altceva?

Vasile, prima mea intrebare pentru tine: „Ați configurat link-urile CNC pe blog?“

Da, CNC este configurat după cum urmează:

Opțiuni - Setări generale - Permalinks - aleatoare - /% categorie% /% postname% /